🔥 Cần Làm Gì Với Tính Năng Web Search Của ChatGPT

· 5 min read

Nguồn: Bình dân học AI

-Tác giả: Đào Anh Tuấn - Admin group Bình dân học AI"

-Facebook: "https://www.facebook.com/daoanhtuanmdc/"

1. Bước 1: Nhập prompt yêu cầu tìm kiếm theo cú pháp tìm kiếm của Google

2. Thực hành

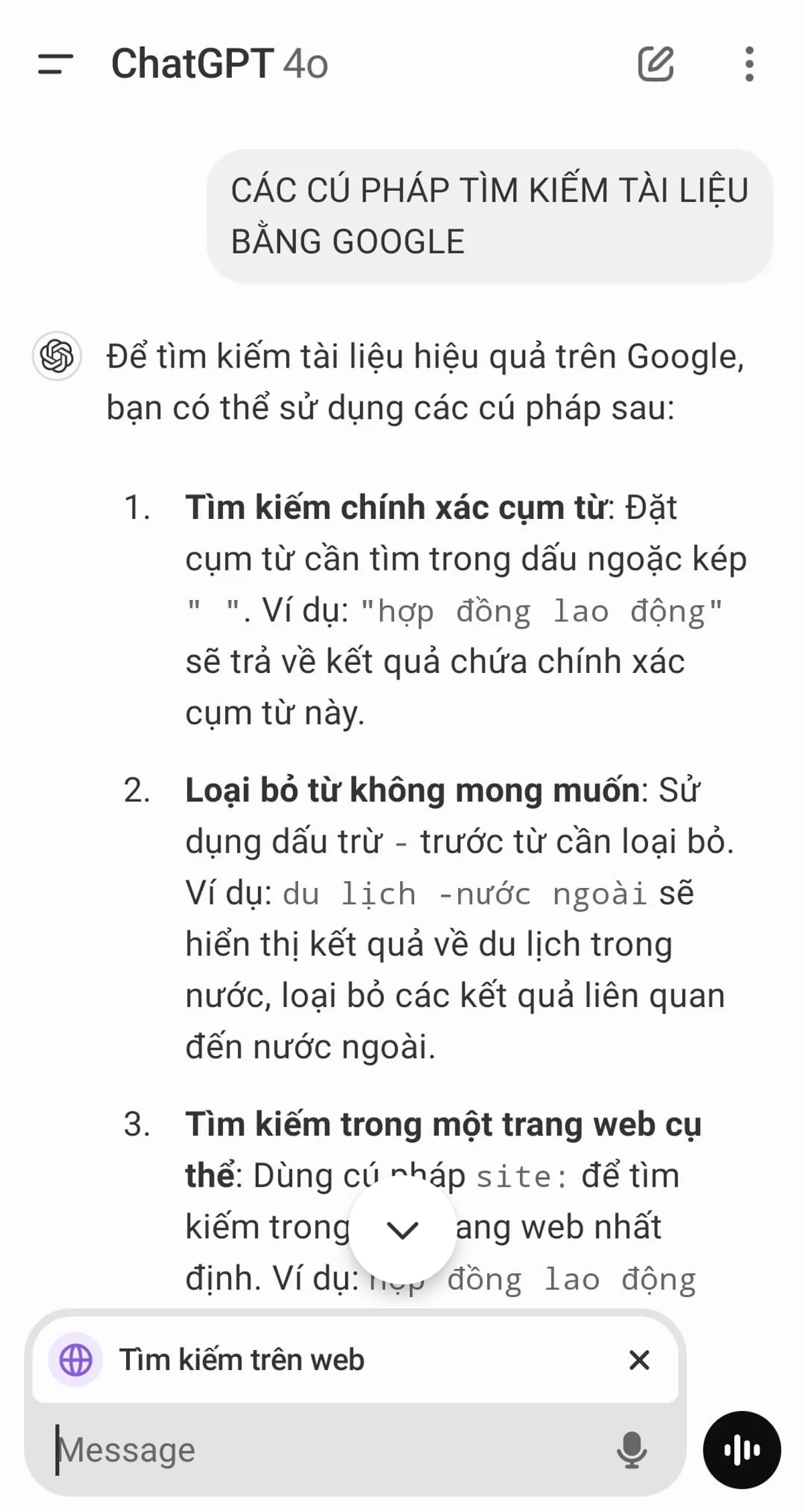

- Hình 1. Các cú pháp tìm kiếm của Google, áp dụng trong prompt

- Hình 2. Ví dụ minh họa

Ví dụ copy prompt sau:

Các cú pháp tìm kiếm tài liệu bằng Google

Kết quả từ ChatGPT search

Để tìm kiếm tài liệu hiệu quả trên Google, bạn có thể sử dụng các cú pháp sau:

1. Tìm kiếm chính xác cụm từ: Đặt cụm từ trong dấu ngoặc kép " " để tìm kết quả chứa chính xác cụm từ đó.

• Ví dụ: "học máy" sẽ trả về các trang chứa chính xác cụm từ "học máy".

2. Loại bỏ từ không mong muốn: Sử dụng dấu trừ - trước từ cần loại bỏ khỏi kết quả tìm kiếm.

• Ví dụ: lập trình -Java sẽ trả về các trang về lập trình nhưng không chứa từ "Java".

3. Tìm kiếm trong một trang web cụ thể: Dùng cú pháp site: để tìm từ khóa trong một trang web nhất định.

• Ví dụ: AI site:example.com sẽ tìm các trang trên example.com có chứa từ "AI".

4. Tìm kiếm theo loại tệp tin: Sử dụng filetype: để tìm các tệp có định dạng cụ thể.

• Ví dụ: báo cáo tài chính filetype:pdf sẽ trả về các tệp PDF liên quan đến báo cáo tài chính.

5. Tìm kiếm từ khóa trong tiêu đề trang: Dùng intitle: để tìm các trang có tiêu đề chứa từ khóa.

• Ví dụ: intitle:"học sâu" sẽ trả về các trang có tiêu đề chứa cụm từ "học sâu".

6. Tìm kiếm từ khóa trong URL: Sử dụng inurl: để tìm các trang có URL chứa từ khóa.

• Ví dụ: inurl:python sẽ trả về các trang có URL chứa từ "python".

7. Tìm kiếm từ khóa trong nội dung trang: Dùng intext: để tìm các trang có nội dung chứa từ khóa.

• Ví dụ: intext:"máy học" sẽ trả về các trang có nội dung chứa cụm từ "máy học".

8. Tìm kiếm các trang liên quan: Sử dụng related: để tìm các trang web liên quan đến một trang web cụ thể.

• Ví dụ: related:example.com sẽ trả về các trang web liên quan đến example.com.

9. Sử dụng dấu sao (*) cho từ không nhớ: Dùng * để thay thế cho từ hoặc cụm từ bạn không nhớ trong tìm kiếm.

• Ví dụ: "học * trong trí tuệ nhân tạo" sẽ trả về các kết quả như "học sâu trong trí tuệ nhân tạo" hoặc "học máy trong trí tuệ nhân tạo".

10. Tìm kiếm trong khoảng thời gian xác định: Sử dụng .. giữa hai mốc thời gian để giới hạn kết quả trong khoảng đó.

• Ví dụ: công nghệ AI 2015..2020 sẽ trả về các kết quả liên quan đến công nghệ AI trong giai đoạn từ 2015 đến 2020.

Áp dụng các cú pháp trên sẽ giúp bạn tìm kiếm thông tin trên Google một cách nhanh chóng và chính xác hơn.

Tiếp tục Prompt tiếp theo:

In-depth search the best papers relevant "CoT prompting technique" on site:arxiv.org

Kết quả cuối cùng:

Chain-of-Thought (CoT) prompting is a technique designed to enhance the reasoning capabilities of large language models (LLMs) by encouraging them to generate intermediate reasoning steps leading to a final conclusion. This approach has been instrumental in improving performance on tasks requiring complex, multi-step reasoning.

Here are some seminal papers on CoT prompting available on arXiv.org:

1. "Chain-of-Thought Prompting Elicits Reasoning in Large Language Models" by Jason Wei et al. (2022): This foundational paper introduces the concept of CoT prompting, demonstrating that providing LLMs with examples of intermediate reasoning steps significantly enhances their performance on arithmetic, commonsense, and symbolic reasoning tasks.

2. "Automatic Chain of Thought Prompting in Large Language Models" by Zeyu Feng et al. (2022): This study explores methods to automate the generation of CoT prompts, reducing the reliance on manually crafted examples. The authors propose techniques to elicit reasoning in LLMs without extensive human intervention.

3. "Towards Understanding Chain-of-Thought Prompting: An Empirical Study of What Matters" by Boshi Wang et al. (2022): This empirical study investigates the factors contributing to the effectiveness of CoT prompting. The authors analyze various components of the reasoning chains to determine their impact on model performance.

4. "Stress Testing Chain-of-Thought Prompting for Large Language Models" by Aayush Mishra and Karan Thakkar (2023): This paper examines the robustness of CoT prompting under different conditions, providing insights into its strengths and limitations across various reasoning tasks.

5. "Plan-and-Solve Prompting: Improving Zero-Shot Chain-of-Thought" by Xuhui Zhou et al. (2023): The authors introduce a novel prompting strategy that enhances zero-shot CoT reasoning by guiding LLMs to devise a plan before generating the solution, leading to improved performance on complex tasks.

These papers collectively provide a comprehensive understanding of CoT prompting techniques, their development, and their application in enhancing the reasoning abilities of large language models.

Chain-of-Thought (CoT) prompting is a technique designed to enhance the reasoning capabilities of large language models (LLMs) by encouraging them to generate intermediate reasoning steps leading to a final conclusion. This approach has been instrumental in improving performance on tasks requiring complex, multi-step reasoning.