✨ Prompt Engineering ChatGPT A - Z: 6 Chiến Lược Cốt Lõi từ OpenAI ✨

Facebook: "https://www.facebook.com/frank.t96/"

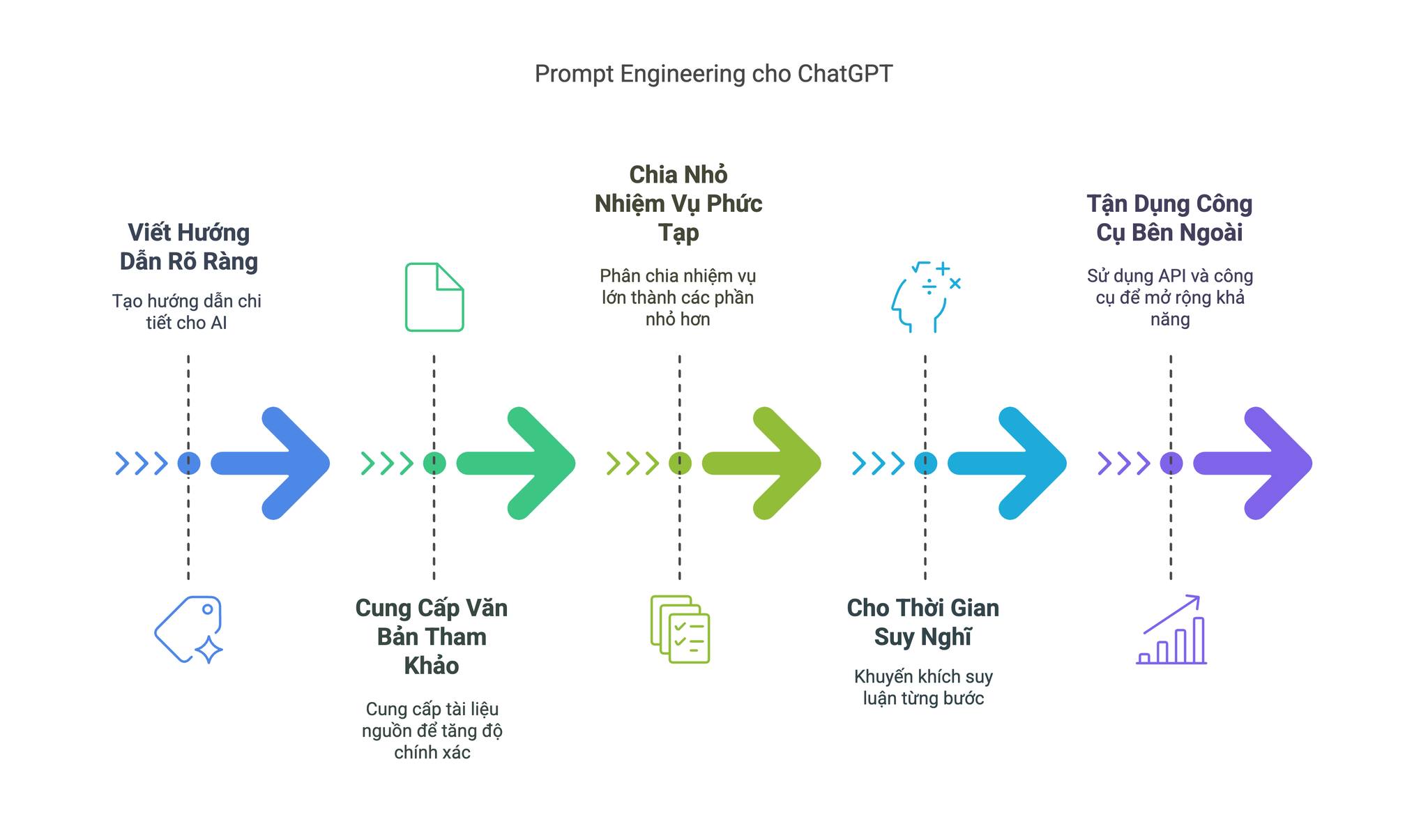

Prompt engineering là chìa khóa để khai thác sức mạnh tối đa của các mô hình ngôn ngữ lớn (LLMs) như GPT-4o. OpenAI đã đưa ra hướng dẫn chi tiết về 6 chiến lược cốt lõi, giúp bạn tối ưu hóa tương tác và đạt được kết quả mong muốn. Bài viết này sẽ tổng hợp toàn bộ hướng dẫn, cung cấp một cái nhìn toàn diện và dễ áp dụng.

✍️ 1. Viết Hướng Dẫn Rõ Ràng: Chi Tiết Là Chìa Khóa ✨

Để hệ thống AI hiểu chính xác bạn muốn gì, hướng dẫn của bạn cần phải rõ ràng và chi tiết. Điều này bao gồm việc cung cấp đầy đủ ngữ cảnh, định dạng mong muốn và các yêu cầu cụ thể khác.

Thay vì một prompt mơ hồ như:

Summarize meeting notes

Hãy cung cấp một prompt chi tiết hơn để đạt được kết quả tốt nhất:

Summarize notes in 1 paragraph, list speakers' key points in markdown, then outline action items

Các yếu tố quan trọng để viết hướng dẫn rõ ràng:

- Chi tiết ngữ cảnh: Cung cấp thông tin nền cần thiết để mô hình hiểu rõ nhiệm vụ.

- Định dạng đầu ra: Chỉ định rõ định dạng mong muốn (ví dụ: đoạn văn, danh sách, bảng markdown, JSON).

- Độ dài câu trả lời: Đặt giới hạn về độ dài nếu cần thiết (ví dụ: "trong 100 từ", "không quá 3 đoạn").

- Sử dụng Persona: Chỉ định vai trò cho mô hình thông qua system message để định hình giọng văn và phong cách phản hồi (ví dụ: "Bạn là một chuyên gia marketing dày dặn kinh nghiệm").

- Delimiters (Dấu phân tách): Sử dụng các dấu đặc biệt như ``` hoặc thẻ XML để phân tách các phần khác nhau của prompt (hướng dẫn, ngữ cảnh, văn bản tham khảo) và tránh nhầm lẫn.

Ví dụ về sử dụng Delimiters cho nhiệm vụ dịch thuật:

### Hướng Dẫn

Dịch tài liệu kỹ thuật này sang tiếng Tây Ban Nha, sử dụng ngôn ngữ kinh doanh trang trọng.

### Văn Bản

[Nội dung cần dịch]

📚 2. Cung Cấp Văn Bản Tham Khảo: Nền Tảng Cho Phản Hồi Chính Xác 🔍

Để giảm thiểu hiện tượng "ảo giác" (hallucinations) và đảm bảo câu trả lời dựa trên thực tế, việc cung cấp văn bản tham khảo là vô cùng quan trọng. Khi có tài liệu nguồn, mô hình sẽ có cơ sở để đưa ra phản hồi chính xác và đáng tin cậy hơn.

Bạn có thể hướng dẫn mô hình trích dẫn các đoạn văn từ tài liệu bạn cung cấp để tăng cường độ tin cậy.

Ví dụ về prompt sử dụng văn bản tham khảo:

### Hướng Dẫn

Phân tích hợp đồng này bằng cách sử dụng PDF đính kèm làm tài liệu tham khảo.

### Tài Liệu

[Văn bản trích xuất từ thỏa thuận pháp lý]

### Truy Vấn

Xác định các điều khoản vi phạm bộ luật lao động California điều 1102.5

Kỹ thuật trích dẫn có cấu trúc:

- Trích dẫn nội dòng: "Điều khoản không cạnh tranh (Mục 4.2) có vẻ quá rộng [Tài liệu trang 12]"

- Gắn thẻ nguồn: "Theo hướng dẫn của FDA năm 2023 (Nguồn A), giới hạn liều lượng..."

- Chấm điểm độ tin cậy: "Giải thích này có độ tin cậy trung bình (3/5 nguồn hỗ trợ)"

🧩 3. Chia Nhỏ Nhiệm Vụ Phức Tạp: Quản Lý Dễ Dàng, Hiệu Quả Vượt Trội ✨

Khi đối diện với các nhiệm vụ phức tạp, việc chia nhỏ chúng thành các phần nhỏ hơn là một chiến lược thông minh. Điều này giúp hệ thống AI quản lý quy trình làm việc hiệu quả hơn, giảm thiểu lỗi và tăng độ chính xác.

Các kỹ thuật phân tách nhiệm vụ:

- Tóm Tắt Phân Cấp: Tóm tắt từng phần nhỏ, sau đó tóm tắt các bản tóm tắt để có được bản tóm tắt tổng quan cho tài liệu dài.

- Phân Loại Ý Định: Xác định ý định của người dùng để định tuyến truy vấn đến quy trình làm việc phù hợp (ví dụ: hỗ trợ thanh toán, khắc phục sự cố kỹ thuật).

- Phân Tích Đệ Quy: Chia vấn đề lớn thành các vấn đề con, phân tích từng vấn đề con, sau đó tổng hợp thành giải pháp toàn diện.

Ví dụ về quy trình phân tích tài liệu phức tạp:

- Chia nhỏ (Chunking): Chia báo cáo 100 trang thành các phần (giới thiệu, phương pháp luận, kết quả).

- Tóm tắt phần (Section Summaries): Tóm tắt mỗi phần trong khoảng 100 từ.

- Tóm tắt phân cấp (Hierarchical Summarization): Kết hợp các bản tóm tắt phần thành một bản tóm tắt báo cáo duy nhất.

- Trích xuất khuyến nghị (Recommendation Extraction): Xác định và liệt kê tất cả các khuyến nghị từ bản tóm tắt báo cáo.

⏳ 4. Cho Mô Hình "Thời Gian Suy Nghĩ": Suy Luận Sâu Sắc, Kết Quả Chất Lượng 🧠

Để khuyến khích mô hình suy luận kỹ lưỡng hơn trước khi đưa ra câu trả lời, hãy cho mô hình "thời gian suy nghĩ". Các kỹ thuật như Chain-of-Thought giúp mô hình trình bày quá trình suy luận từng bước, dẫn đến kết quả chính xác và dễ hiểu hơn. (Các reasoning model như O1/O3 series đều đã được tích hợp Chain-of-Thought)

Kỹ thuật "thời gian suy nghĩ":

-

Lập Luận Chuỗi Suy Nghĩ (Chain-of-Thought): Yêu cầu mô hình giải thích từng bước suy luận trước khi đưa ra câu trả lời cuối cùng.

Ví dụ prompt Chain-of-Thought:

First, calculate the area of the rectangle. Then, determine the perimeter. Finally, compare these values to the given constraints. -

Độc Thoại Nội Tâm Ẩn (Hidden Inner Monologue): Mô hình thực hiện suy luận chi tiết bên trong, nhưng chỉ hiển thị câu trả lời cuối cùng cho người dùng, giúp giảm độ dài dòng đầu ra mà vẫn duy trì độ chính xác.

🛠️ 5. Tận Dụng Công Cụ Bên Ngoài: Mở Rộng Khả Năng, Kết Nối Dữ Liệu Động 🔗

Để vượt qua giới hạn kiến thức tĩnh của mô hình, hãy tận dụng các công cụ bên ngoài. Kết nối mô hình với các nguồn dữ liệu động và hệ thống chuyên biệt giúp mở rộng khả năng và cung cấp thông tin cập nhật, chính xác.

Các loại công cụ bên ngoài hữu ích:

- Tìm Kiếm Embeddings: Truy xuất thông tin liên quan từ cơ sở dữ liệu vector để cung cấp kiến thức động.

- Thực Thi Mã: Sử dụng trình thông dịch Python để thực hiện các phép toán phức tạp hoặc xử lý dữ liệu.

- Gọi Hàm: Tích hợp API để truy cập dữ liệu thời gian thực (ví dụ: API thời tiết, API tài chính) và tương tác với các dịch vụ khác.

- API Tùy Chỉnh: Kết nối với các nguồn dữ liệu và hệ thống nội bộ của bạn thông qua API riêng.

Ví dụ về tích hợp API thời tiết:

import requests

def get_weather(location):

api_key = "YOUR_API_KEY"

response = requests.get(f"https://api.weatherapi.com/v1/current.json?key={api_key}&q={location}")

return response.json()

# Hướng dẫn cho mô hình:

"Chuyển đổi yêu cầu vị trí của người dùng sang định dạng JSON để gọi API"

✅ 6. Kiểm Thử Hệ Thống: Đảm Bảo Hiệu Suất Ổn Định, Tin Cậy Vượt Trội 🧪

Để đảm bảo hệ thống AI hoạt động ổn định và đáng tin cậy, kiểm thử hệ thống là bước không thể thiếu. Xây dựng bộ kiểm thử toàn diện và thực hiện kiểm thử thường xuyên giúp phát hiện và khắc phục lỗi, đảm bảo chất lượng đầu ra.

Chiến lược kiểm thử hệ thống:

- Thiết Kế Trường Hợp Kiểm Thử: Bao gồm các loại trường hợp kiểm thử khác nhau: trường hợp sử dụng phổ biến, trường hợp đặc biệt (edge cases) và trường hợp đối nghịch (adversarial).

- Khung Đo Lường Đánh Giá: Xác định các chỉ số quan trọng để đánh giá hiệu suất (độ chính xác, độ trễ, độ an toàn, tính nhất quán).

- Tự Động Hóa Kiểm Thử: Sử dụng trình chạy kiểm thử tự động để thực hiện kiểm thử nhanh chóng và hiệu quả.

- Kiểm Thử A/B: So sánh hiệu suất của các phiên bản prompt khác nhau trong môi trường thực tế.

- Cải Tiến Liên Tục: Thực hiện kiểm thử hồi quy, kiểm soát phiên bản prompt và phân tích lỗi để liên tục cải thiện hệ thống.

Ví dụ về lớp PromptTestSuite cho kiểm thử tự động:

class PromptTestSuite:

def __init__(self, test_cases):

self.cases = test_cases

def run(self, model):

results = []

for case in self.cases:

output = model.generate(case["input"])

score = self.evaluate(output, case["expected"])

results.append(score)

return statistics.mean(results)

def evaluate(self, output, expected):

# Triển khai tính toán các chỉ số

pass

Kết luận:

Prompt engineering là một lĩnh vực phát triển nhanh chóng, và việc nắm vững 6 chiến lược cốt lõi này sẽ giúp bạn tận dụng tối đa sức mạnh của các mô hình ngôn ngữ lớn. Bằng cách viết hướng dẫn rõ ràng, cung cấp văn bản tham khảo, chia nhỏ nhiệm vụ phức tạp, cho mô hình thời gian suy nghĩ, tận dụng công cụ bên ngoài và kiểm thử hệ thống một cách có hệ thống, bạn có thể xây dựng các ứng dụng AI mạnh mẽ, đáng tin cậy và hiệu quả. Hãy bắt đầu thử nghiệm và khám phá tiềm năng to lớn của prompt engineering! 🚀