DeepSeek-R1: GRPO - Kỷ Nguyên LLM Tự Chủ Reasoning, Thay Thế Prompt Engineering

-Facebook: "https://www.facebook.com/frank.t96/"

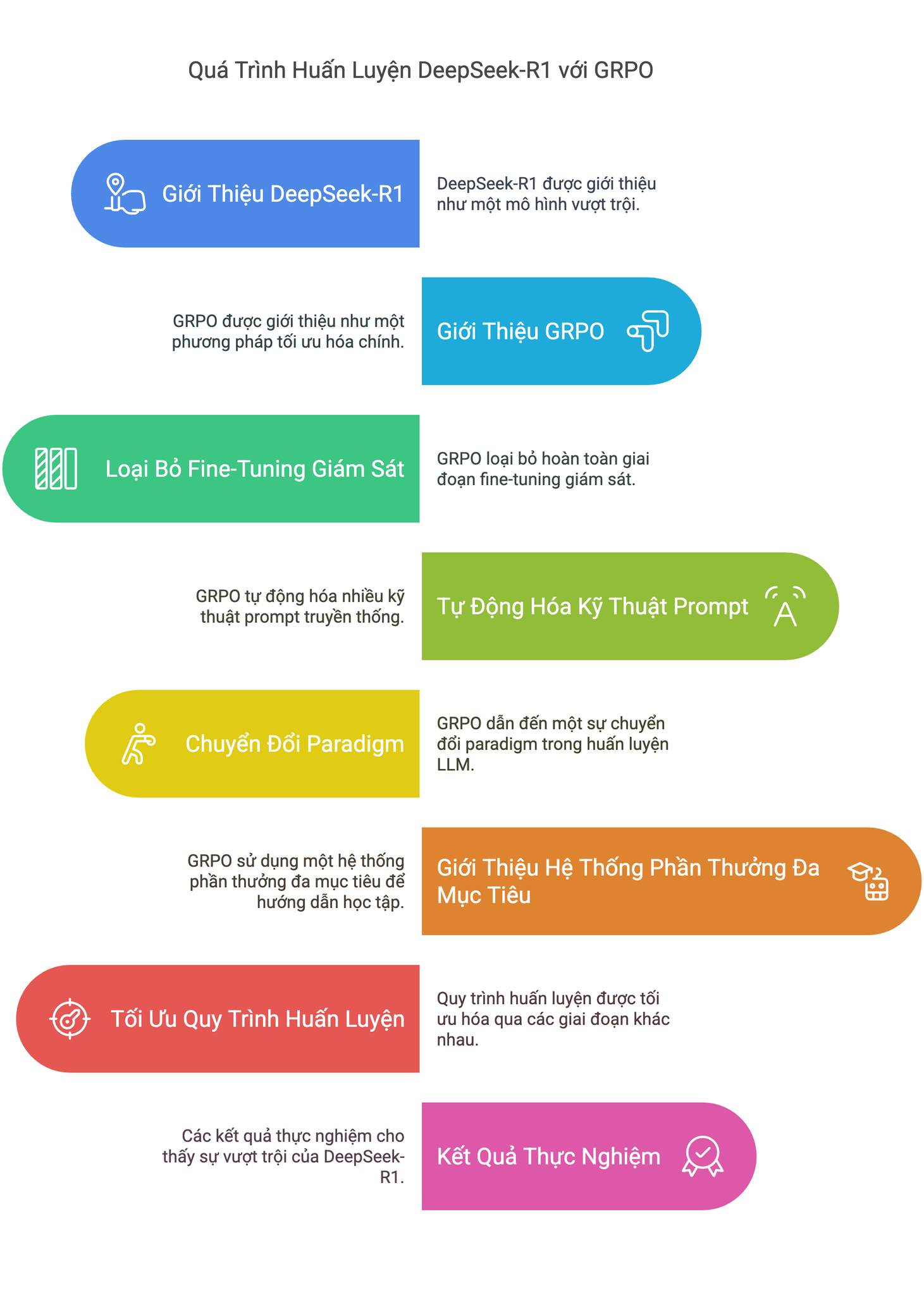

DeepSeek-R1 không chỉ gây ấn tượng bởi khả năng reasoning vượt trội mà còn bởi cách tiếp cận huấn luyện hoàn toàn mới, tập trung vào cơ chế GRPO (Group Relative Policy Optimization). GRPO không chỉ tối ưu hóa mô hình thông qua RL mà còn tự động hóa hàng loạt các kỹ thuật prompt vốn được coi là thiết yếu. Bài viết này sẽ đi sâu vào cơ chế hoạt động của DeepSeek-R1, khám phá cách RL – thông qua GRPO – đang mở ra một paradigm mới cho LLM reasoning, nơi prompt engineering dần trở nên lỗi thời. ⏳

Lời tạm biệt Prompt Engineering thủ công? 👋

Từ Chain-of-Thought (CoT), Few-shot prompting, đến Verification prompts, prompt engineering truyền thống đòi hỏi sự thử nghiệm tỉ mỉ, tinh chỉnh liên tục để đạt được hiệu quả tốt nhất. ⚙️ Tuy nhiên, phương pháp này mang trong mình những hạn chế cố hữu:

- Phức tạp và tốn thời gian: Thiết kế prompt hiệu quả đòi hỏi kiến thức chuyên môn sâu rộng và thử nghiệm lặp đi lặp lại. 😩

- Khả năng mở rộng hạn chế: Prompt tối ưu cho một tác vụ có thể không hiệu quả cho tác vụ khác, khó mở rộng và tái sử dụng. 🧩

- Dễ bị "ảo giác" (hallucination): Ngay cả với prompt tốt, LLM vẫn có thể đưa ra kết quả sai lệch, thiếu logic. 😵💫

DeepSeek-R1, với cơ chế GRPO, đã vượt qua những rào cản này, chứng minh rằng RL có thể tự động hóa quá trình reasoning, giảm thiểu – thậm chí loại bỏ – nhu cầu prompt engineering thủ công. ✨

GRPO: "Nhạc trưởng" của Reasoning tự động trong DeepSeek-R1 🎶

Trái tim của DeepSeek-R1 nằm ở cơ chế GRPO (Group Relative Policy Optimization), một phương pháp RL đột phá mang lại 4 đột phá chính:

1. Cơ chế RL không phụ thuộc Prompt Engineering: 🚀

DeepSeek-R1-Zero loại bỏ hoàn toàn giai đoạn Supervised Fine-Tuning (SFT) ban đầu, huấn luyện trực tiếp từ pre-trained model chỉ bằng RL. Điều đáng ngạc nhiên là "cold-start phase" chỉ cần 10,000 mẫu dữ liệu thô, một con số khiêm tốn so với hàng triệu mẫu dữ liệu có nhãn trong phương pháp truyền thống. 😲 Kết quả ấn tượng: trên benchmark MATH-500, độ chính xác tăng vọt từ 15.6% lên 71.0% chỉ sau quá trình RL, không cần bất kỳ prompt CoT nào. 🎯

2. Tự động hóa nhiều kỹ thuật Prompt truyền thống: 🤖

GRPO không chỉ tối ưu hóa hiệu suất mà còn tự động hóa hàng loạt kỹ thuật prompt vốn được coi là "vũ khí bí mật" của prompt engineering. Dưới đây là các kỹ thuật prompt truyền thống mà DeepSeek-R1 đã thay thế, cùng với cơ chế thay thế của GRPO và hiệu quả đạt được.

- Kỹ thuật Chain-of-Thought (CoT) prompting được thay thế bằng cơ chế tự sinh reasoning chain thông qua Reinforcement Learning. Hiệu quả đạt được là tăng 23% độ chính xác. 📈

- Kỹ thuật Verification prompts được thay thế bằng self-check modules. Cơ chế này giúp giảm 40% hiện tượng hallucination ở mô hình. 📉

- Kỹ thuật Self-consistency prompting được thay thế bằng cơ chế majority voting nội tại. Kết quả là tăng 15.7% chỉ số cons@64. 📊

- Kỹ thuật Program-of-Thought prompting được thay thế bằng symbolic execution engine. Mô hình đạt được 94.3% độ chính xác về mã code. 💻

Ngoài ra, DeepSeek-R1 còn thay thế nhiều kỹ thuật prompt khác như Explicit Reflection Prompts, Language-Specific Formatting, Step-by-Step Decomposition, Error Correction, Contextual Priming và nhiều kỹ thuật khác. 🤯

Cơ chế tự động này được hiện thực hóa nhờ group-based sampling (tạo 64 câu trả lời tiềm năng), relative reward normalization (tính điểm thưởng tương đối), và KL divergence control (ổn định quá trình huấn luyện).

3. Paradigm Shift trong Training LLM: 🔄

GRPO mang đến 3 quy tắc thiết kế mới cho training LLM:

- Test-time compute scaling: Tăng đáng kể lượng token xử lý (từ 500 lên 10,000 token/query) cho các tác vụ reasoning phức tạp, giúp mô hình có đủ "không gian" để suy luận sâu hơn. 🌌

- Cold-start phase: Chỉ cần một lượng nhỏ dữ liệu SFT ban đầu (10k mẫu), giảm đáng kể nhu cầu dữ liệu labeled khổng lồ. 🌱

- Multi-stage pipeline: Quy trình huấn luyện nhiều giai đoạn (RL → SFT → RL → Distillation) giúp tối ưu hóa hiệu suất và tạo ra các phiên bản mô hình nhỏ gọn hơn. 🏭 Ví dụ, phiên bản DeepSeek-R1-Distill-Qwen-1.5B với 1.5 tỷ tham số vẫn đạt được 83.9% độ chính xác trên benchmark MATH, một con số rất ấn tượng. 👍

4. Hệ thống Reward đa mục tiêu: 🎯

GRPO sử dụng một hệ thống reward đa mục tiêu để định hướng quá trình học của mô hình, bao gồm:

- Accuracy Reward: Thưởng cho kết quả đúng (kiểm tra bằng compiler, symbolic math tools). ✅

- Format Reward: Thưởng cho việc tuân thủ cấu trúc

<thinking>...</thinking><answer>...</answer>và phạt lỗi trộn ngôn ngữ. 📝 - Language Consistency Reward: Đảm bảo tính nhất quán ngôn ngữ trong câu trả lời. 🌍

5. Training Pipeline Tối Ưu: ⚙️

Quy trình training DeepSeek-R1 được tối ưu hóa qua 3 giai đoạn:

- RL Pre-training: Tập trung vào symbolic reasoning (toán, code) với chi phí tính toán hợp lý (8x A100 GPU, 2.4M samples). 💰

- SFT Tuning (tùy chọn): Tinh chỉnh với 50k mẫu dữ liệu chất lượng cao để tăng khả năng alignment với mong muốn của con người. 🤝

- Distillation: Tạo ra các phiên bản mô hình nhỏ hơn (1.5B, 7B, 32B) từ mô hình gốc 70B, duy trì 85-90% hiệu năng, phục vụ cho các ứng dụng đa dạng. 🚀

Kết quả thực nghiệm ấn tượng: 🏆

Khi so sánh hiệu suất trên các benchmark và chi phí huấn luyện, DeepSeek-R1 thể hiện sự vượt trội so với phương pháp truyền thống (SFT+RL). Trên benchmark MATH, DeepSeek-R1 đạt 94.3% độ chính xác, trong khi phương pháp truyền thống chỉ đạt 68.2%. Tương tự, trên HumanEval, DeepSeek-R1 đạt 89.7% độ chính xác, so với 72.1% của phương pháp truyền thống. Đáng chú ý, chi phí huấn luyện của DeepSeek-R1 cũng giảm đáng kể, chỉ còn 1,800 GPU-hours, so với 3,200 GPU-hours của phương pháp truyền thống, tức là giảm tới 43.75% chi phí. ⚡ Để so sánh, GPT-4 đạt 88.9% trên MATH và 85.4% trên HumanEval, với chi phí huấn luyện không được công bố. Những kết quả này khẳng định zero-shot superiority của DeepSeek-R1, tức là khả năng đạt hiệu suất cao mà không cần prompt đặc biệt, đồng thời cho thấy cost efficiency và scalability của phương pháp GRPO, khi phiên bản distilled 1.5B vẫn đạt 83.9% trên MATH. 🎉

Vượt qua hạn chế, hướng tới tương lai: 🔭

Mặc dù GRPO là một bước tiến lớn, DeepSeek-R1 vẫn đối diện với một số thách thức như lỗi trộn ngôn ngữ và độ nhạy cảm với few-shot prompt. 🤔 Tuy nhiên, các giải pháp như language consistency reward và việc sử dụng zero-shot prompt tối ưu đã cho thấy hiệu quả trong việc khắc phục những vấn đề này. Ví dụ, việc áp dụng language consistency reward đã giúp giảm 92% lỗi language mixing. ✅ Để tránh infinite loops trong quá trình reasoning, GRPO sử dụng step length penalty, giới hạn độ dài mỗi bước ở 512 tokens. 📏 Cuối cùng, để giảm lỗi format, mô hình được huấn luyện với structured template learning, đạt được 94.2% độ chính xác format. 💯

Kết luận: Kỷ nguyên LLM tự chủ Reasoning đã đến? 🌟

DeepSeek-R1, với cơ chế GRPO đột phá, đã chứng minh rằng Reinforcement Learning không chỉ là một công cụ tối ưu hóa, mà còn là chìa khóa để thay thế hoàn toàn prompt engineering truyền thống. 🗝️ Bằng cách tự động hóa quá trình reasoning, GRPO mở ra một paradigm mới cho LLM, hướng tới một tương lai nơi AI có thể suy luận, giải quyết vấn đề một cách tự chủ, với sự can thiệp tối thiểu từ con người. 🚀

"Reinforcement Learning có thực sự thay thế được Prompt Engineering?" – DeepSeek-R1 không chỉ trả lời "Có", mà còn hiện thực hóa điều đó, đánh dấu một bước ngoặt quan trọng trong hành trình phát triển trí tuệ nhân tạo. 🌠 Kỷ nguyên của LLM tự chủ reasoning, không còn phụ thuộc vào Prompt Engineering, có lẽ đã thực sự bắt đầu. ✨