Hướng dẫn cách prompting cho các Reasoning AI model như O1/O3 series & DeepSeek

-Facebook: "https://www.facebook.com/frank.t96/"

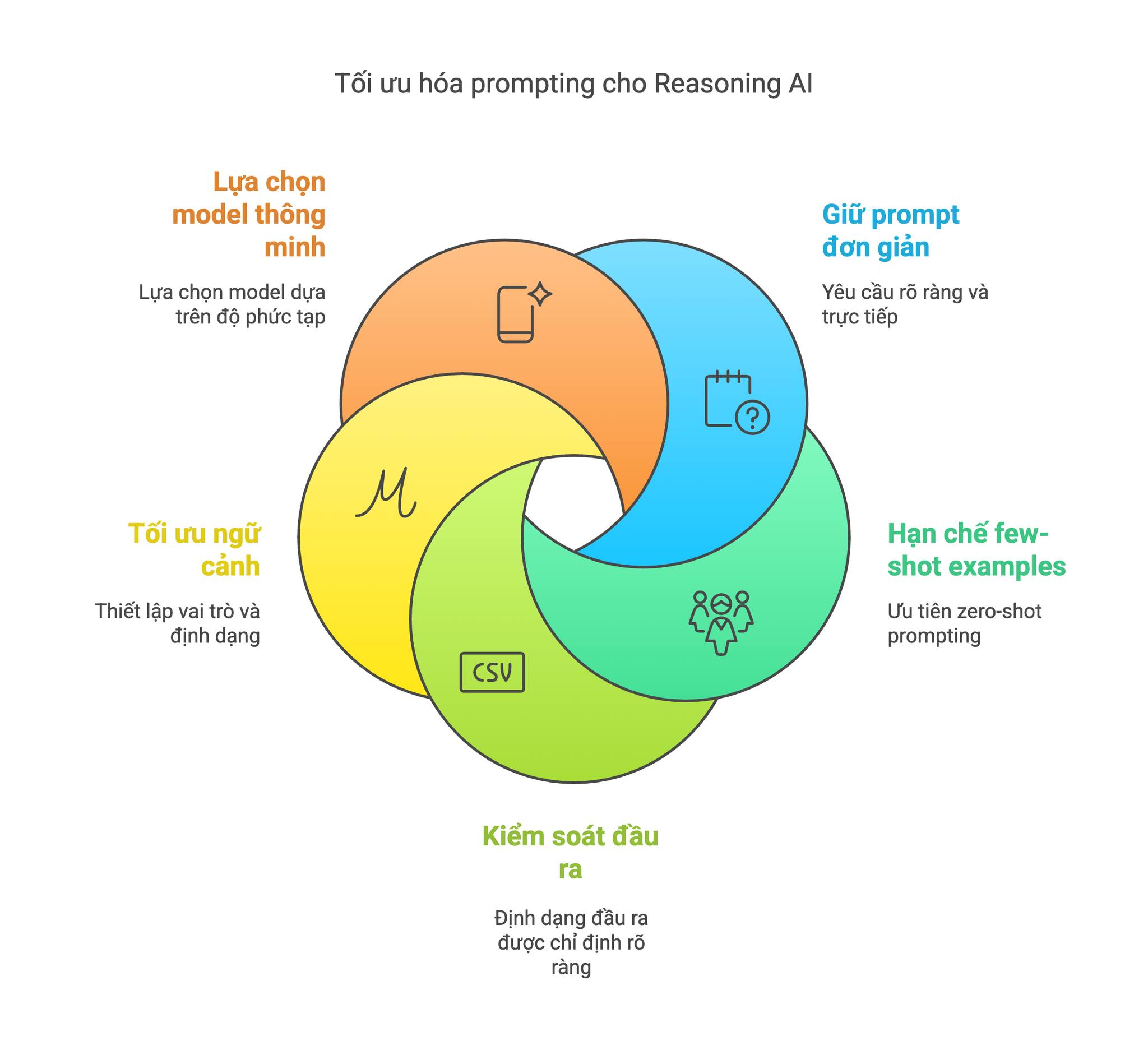

Để tối ưu hiệu suất của các mô hình lý luận (Reasoning AI), cần áp dụng các kỹ thuật prompting khác biệt so với các model truyền thống. Dưới đây là hướng dẫn chi tiết dựa trên nghiên cứu mới nhất:

1. Giữ prompt đơn giản và trực tiếp

- Loại bỏ yếu tố dư thừa: Các model này được thiết kế để tự động phân tích sâu, nên chỉ cần đưa ra yêu cầu chính xác mà không cần hướng dẫn phức tạp. Ví dụ: "Phân tích hợp đồng [nội dung] và xác định rủi ro pháp lý" thay vì "Hãy suy nghĩ cẩn thận từng bước để phân tích..."

- Tránh chain-of-thought (CoT): Không cần thêm cụm từ kích hoạt CoT như "Hãy suy nghĩ từng bước" vì model đã tự thực hiện điều này.

2. Hạn chế few-shot examples

- Ưu tiên zero-shot: Bắt đầu với prompt không ví dụ, chỉ thêm 1 ví dụ đơn giản nếu model hiểu sai yêu cầu. Nghiên cứu cho thấy việc thêm nhiều ví dụ làm giảm 15-20% độ chính xác ở O1.

- Ví dụ hiệu quả:

Hệ thống: Bạn là chuyên gia pháp lý

Người dùng: Phân tích điều khoản bảo mật trong hợp đồng sau...

3. Kiểm soát đầu ra

- Xác định cấu trúc rõ ràng: Chỉ định định dạng đầu ra ngay trong prompt: "Trả lời dạng outline với 3 cấp độ" hoặc "Liệt kê 5 rủi ro chính dưới dạng bullet points".

- Điều chỉnh độ dài: Sử dụng tham số

reasoning_efforttrong API (low/medium/high) để cân bằng giữa tốc độ và độ chi tiết.

4. Tối ưu ngữ cảnh

- Thiết lập vai trò: Định hướng phong cách trả lời bằng system message ngắn gọn: "Bạn là nhà toán học đang giải thích cho sinh viên đại học".

- Cung cấp dữ liệu đầu vào có cấu trúc: Sử dụng dấu phân cách (###, ```) hoặc định dạng bảng để trình bày thông tin phức tạp.

5. Lựa chọn model thông minh

- Dùng reasoning model cho bài toán phức tạp: Những task đòi hỏi suy luận đa bước như phân tích pháp lý, giải toán cao cấp, hoặc debug code phức tạp.

- Chuyển sang model truyền thống cho task đơn giản: Những yêu cầu như dịch thuật, trả lời FAQ, hoặc xử lý văn bản ngắn.

Ví dụ minh họa:

-

Prompt kém hiệu quả:"Trong vai luật sư dày dạn kinh nghiệm, hãy phân tích từng điều khoản một cách chi tiết, xem xét các tình huống giả định có thể xảy ra, sau đó đưa ra đánh giá tổng quan về rủi ro pháp lý..."

-

Prompt tối ưu cho reasoning model:

Phân tích hợp đồng sau:

[Insert contract text]

- Xác định 3 rủi ro pháp lý chính

- Đề xuất điều khoản sửa đổi

- Định dạng đầu ra: JSON với keys: risks, suggestions

Các nghiên cứu gần đây cho thấy phương pháp này giúp tăng 40% độ chính xác và giảm 30% thời gian xử lý so với cách tiếp cận truyền thống. Khi áp dụng đúng, các reasoning model có thể xử lý những bài toán yêu cầu lập luận logic phức tạp mà không cần prompt engineering quá tinh vi.