MÙNG 1 CHẠY DEEPSEEK-R1 LOCAL

-Facebook: "https://www.facebook.com/wincreator1/"

Mùng 1 Nhân tặng quà cho các anh em là một hướng dẫn đơn giản nhất để có thể chạy các model thu gọn [distilled] của DeepSeek-R1 ngay trên máy tính của mình, không cần kết nối internet, và có giao diện dễ dùng, đính kèm được file nhé.

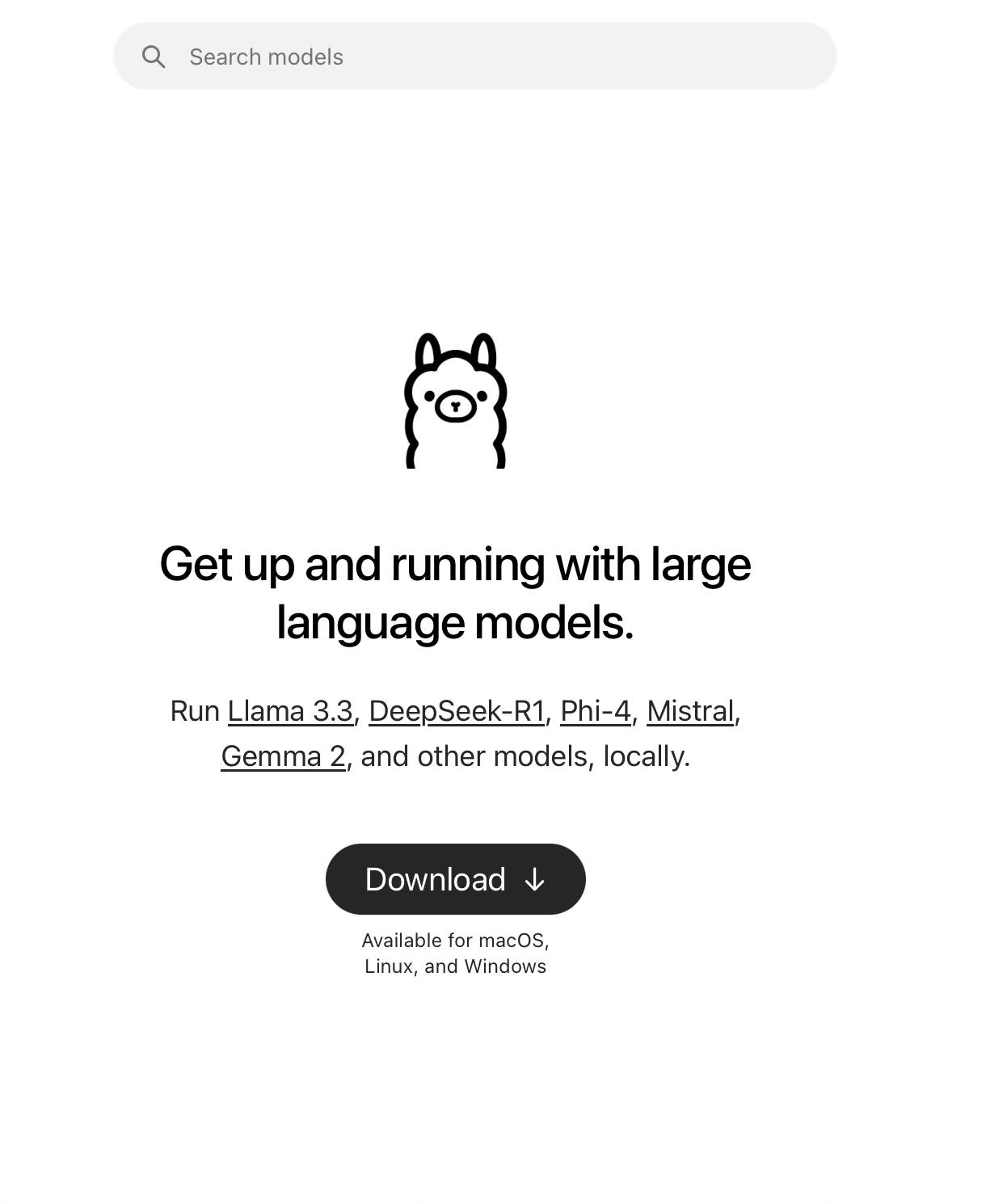

Mọi người sẽ cần cài đặt 2 công cụ sau từ trang web chính hãng của họ (có dưới hình minh hoạ): (1) Ollama để host LLM local, và (2) Chatbox AI để dùng giao diện.

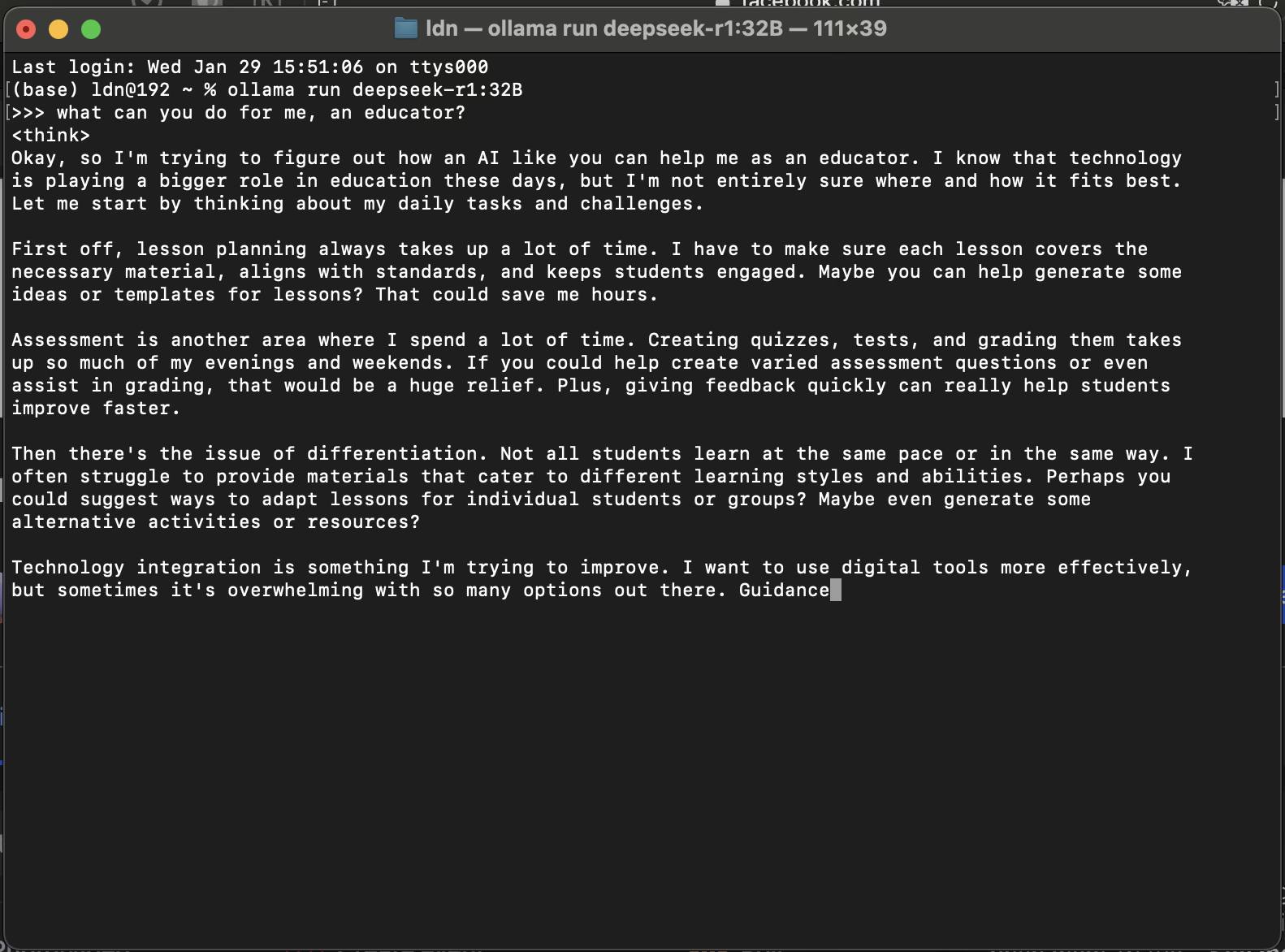

Sau khi cài đặt Ollama thì dùng Terminal hay Command để khởi chạy LLM, trên website của Ollama có hướng dẫn các lệnh tương ứng với từng mô hình. Cơ bản cú pháp sẽ là: "ollama run

Về cơ bản thì sau khi khởi chạy LLM thành công là bạn đã có thể chat với LLM ngay trong cửa sổ dòng lệnh, chat tiếng Việt vẫn ok nha. Nếu cần ra một số lệnh nào đó cho Ollama (như thoát LLM) thì mở đầu bằng dấu xuyệt /.

Khi Ollama đang chạy LLM thì bạn chạy ứng dụng Chatbox AI, đây là một ứng dụng cung cấp giao diện cho LLM và có thể chạy với nhiều LLM khác nhau cả online lẫn offline khá ổn. Bạn có thể gắn API Key của OpenAI, Anthropic Claude, Google Gemini... vào đây để sử dụng trực tiếp các model này.

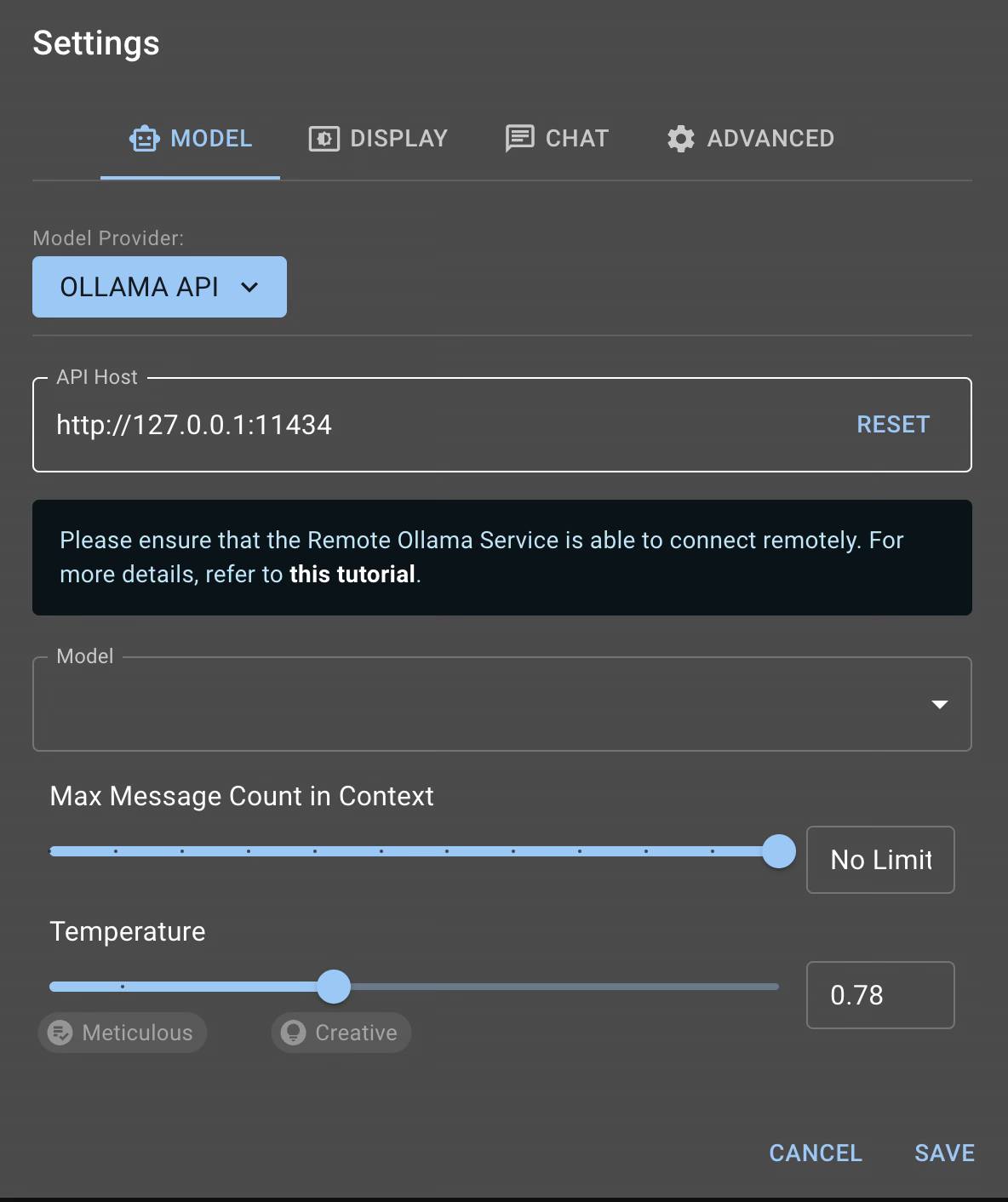

Còn trong hướng dẫn này, để sử dụng DeepSeek-R1 ngay trên máy với giao diện của Chatbox AI, bạn chỉ cần vào Setting, chọn thẻ Model, chọn Model Provider là OLLAMA API, app sẽ tự cấu hình IP, sau đó bạn chọn LLM mà Ollama đang chạy ở dòng Model. Cuối cùng thiết lập Max Message Count in Context và Temperature là xong.

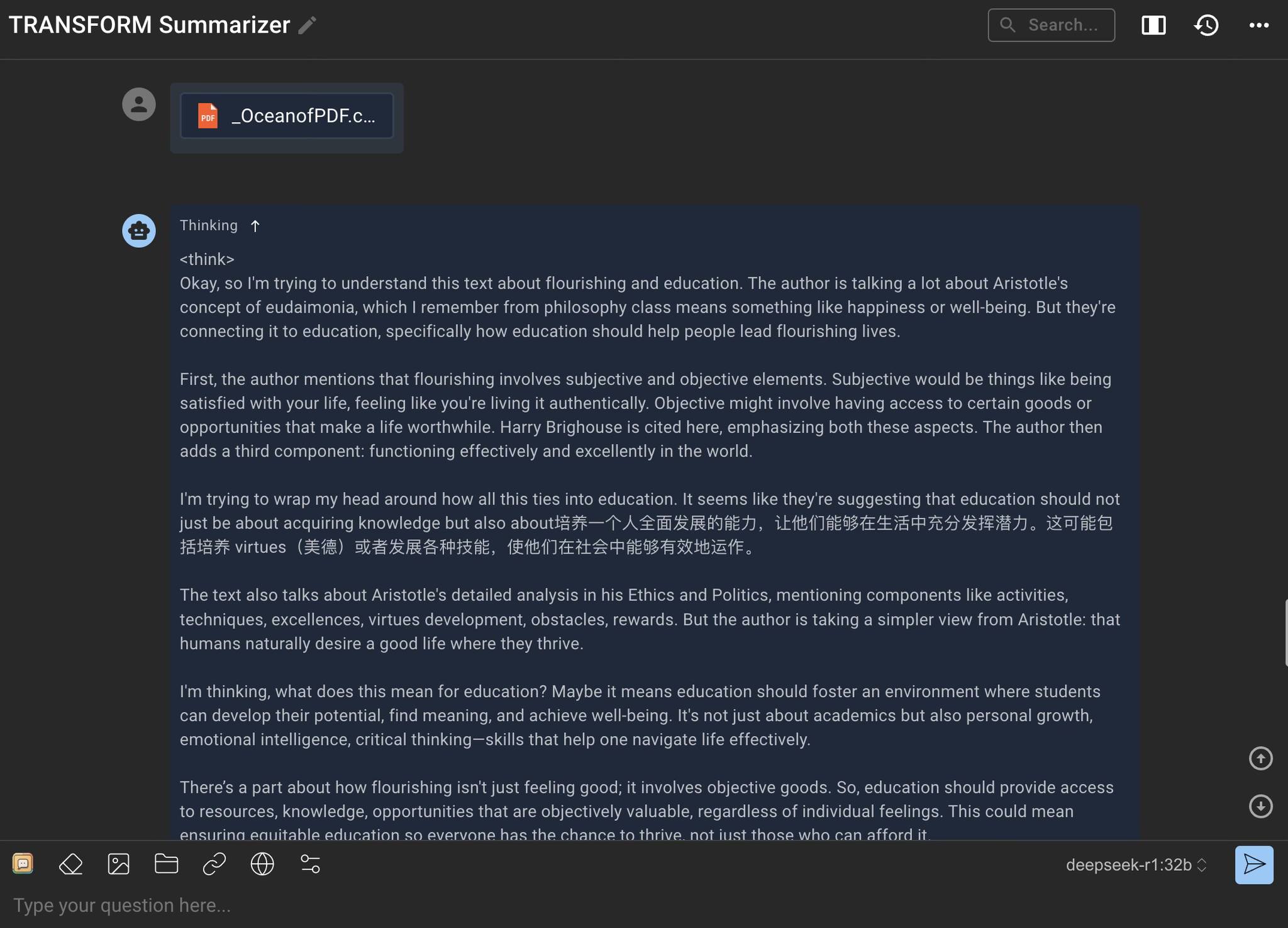

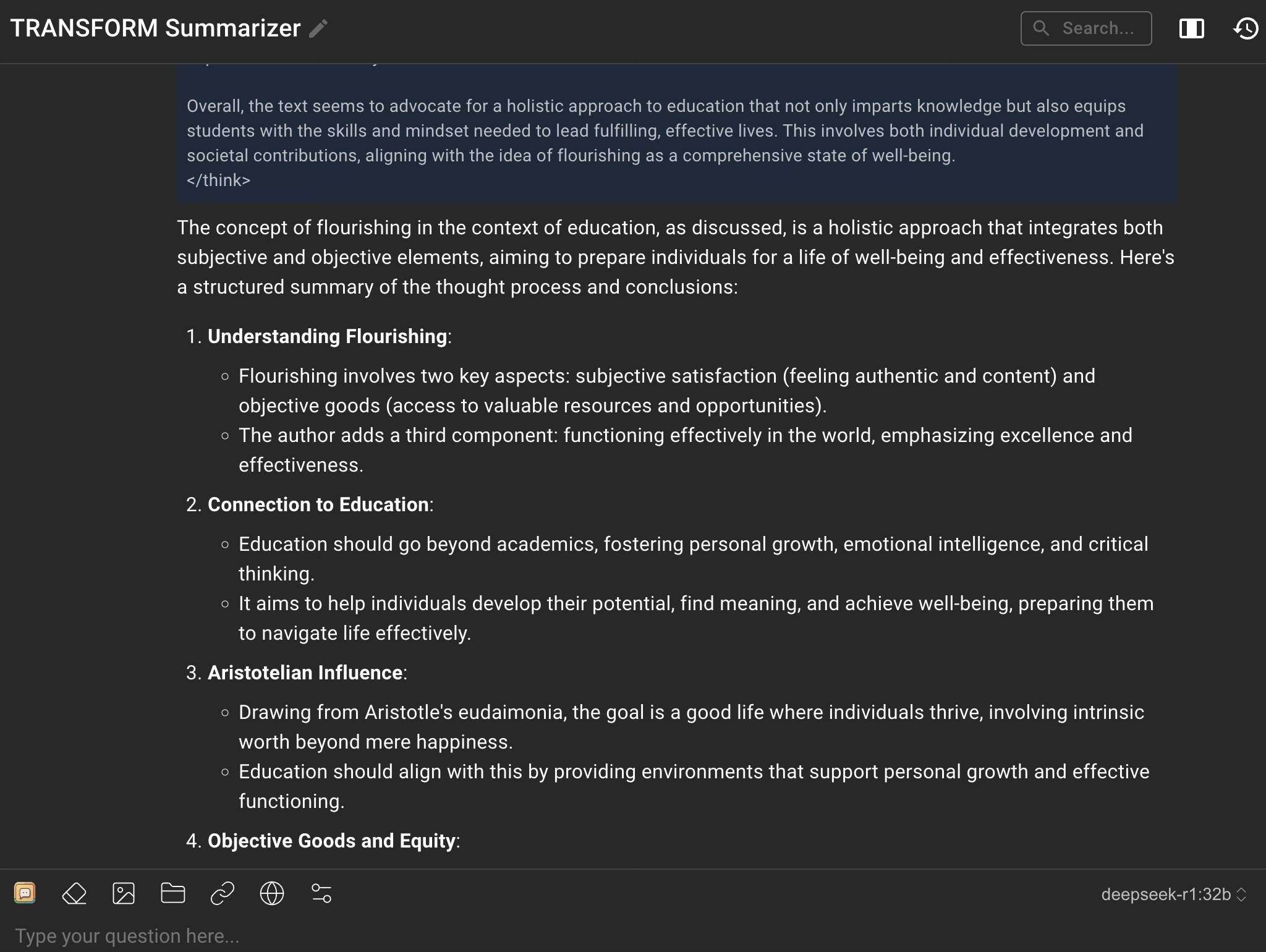

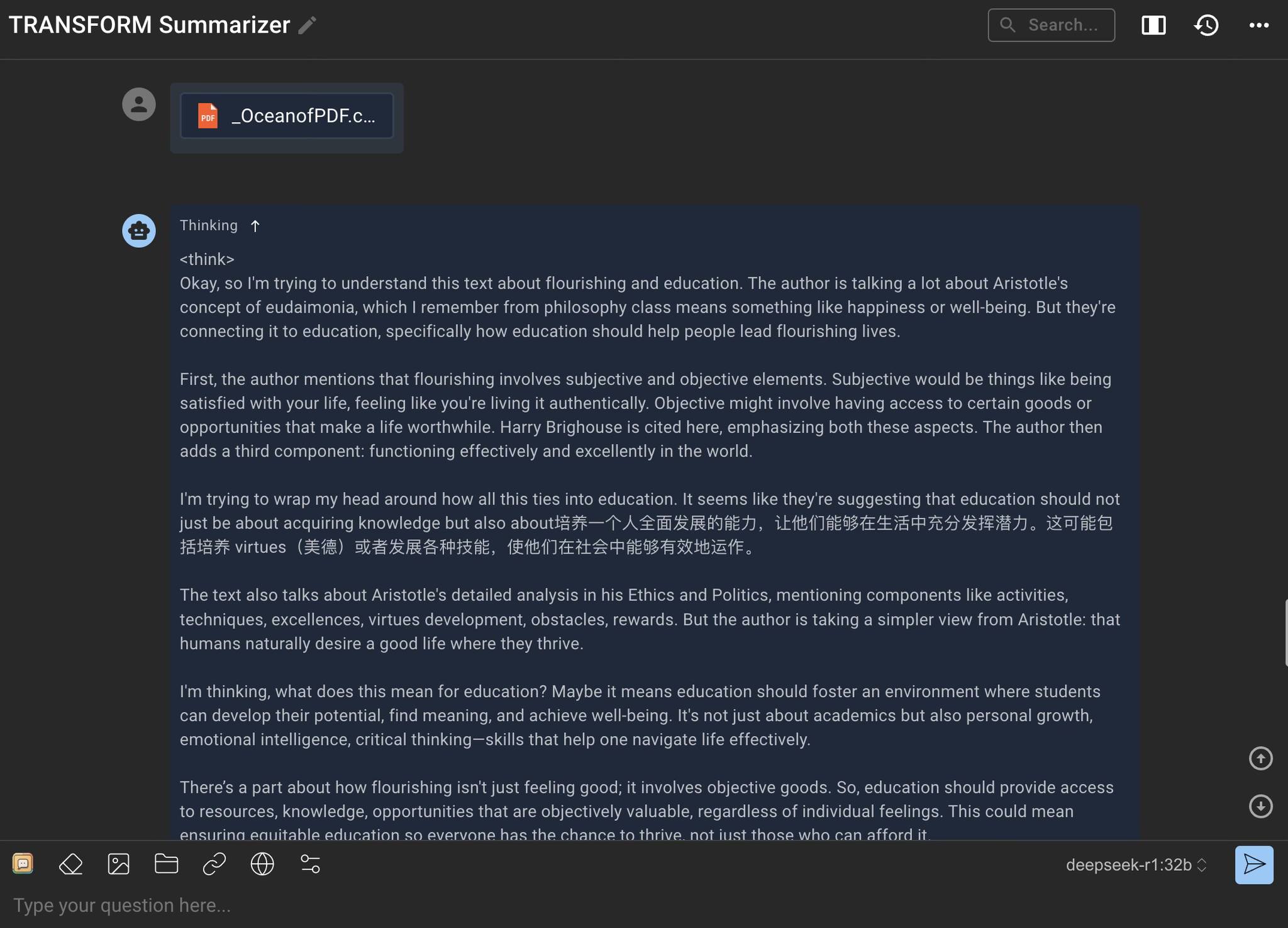

Sau đó bạn bấm New Chat, có những nút ở phía trên ô nhập liệu như cấu hình system prompt, bật chức năng tìm kiếm trên Internet và gắn link (chỉ hoạt động với Google Gemini và Perplexity API), đính kèm file (pdf, doc, ppt, txt...) vừa với context window của LLM, đính kèm ảnh (đọc được hay không cũng tuỳ LLM), và làm mới context.

Máy của Nhân là Macbook Pro M1 Max với 64 GB RAM (đời 2021), chạy DeepSeek-R1 bản "chưng cất" còn 32B khá ổn, trong hình minh hoạ bên dưới Nhân đã tóm tắt một cuốn sách PDF bằng mô hình này.

Chúc các anh chị em chơi vui,